Un data lake est un espace de stockage centralisé conçu pour accueillir de grandes quantités de données, dans leur format brut, sans schéma prédéfini. Contrairement à un data warehouse, qui impose une structure rigide et une modélisation en amont, le data lake accepte toutes les formes de données : structurées (bases de données), semi-structurées (JSON, XML) ou non structurées (PDF, vidéos, logs, images…). L’objectif est de conserver la donnée telle quelle, pour pouvoir l’exploiter ultérieurement selon des besoins encore inconnus au moment de l’ingestion.

Avec la multiplication des sources de données — internes, partenaires, open data, objets connectés, applications métiers — il devient important de disposer d’un espace capable d’absorber ces flux sans contrainte de format ou de volume. Le data lake répond à ce besoin de souplesse et d’évolutivité.

Il permet notamment :

Le data lake devient une mémoire organisationnelle durable, qui laisse toutes les portes ouvertes pour la valorisation future des données.

Le principe du data lake est simple : collecter et stocker les données dans leur format natif, sans transformation immédiate. L’ingestion est rapide, massive, et peu contraignante. La structuration intervient plus tard, au moment de l’usage. C’est ce qu’on appelle le schéma “on read”, à l’inverse du schéma “on write” imposé dans un entrepôt de données.

Concrètement, une entreprise peut centraliser dans son data lake :

Ces données sont stockées dans un environnement cloud (comme Amazon S3, Azure Data Lake Storage, Google Cloud Storage), organisées par zones (raw, cleaned, curated…) et accessibles via des outils d’analyse, des notebooks, ou des moteurs de requêtes.

Même s’ils sont souvent complémentaires, le data lake et le data warehouse répondent à des logiques très différentes. Il est important de bien les distinguer pour construire une architecture data cohérente.

Le data lake se caractérise par :

À l’inverse, le data warehouse est :

Dans une architecture moderne, les deux coexistent souvent. Le data lake joue le rôle de “zone d’atterrissage” brute, tandis que le data warehouse devient la “zone de confiance” exploitée par les métiers.

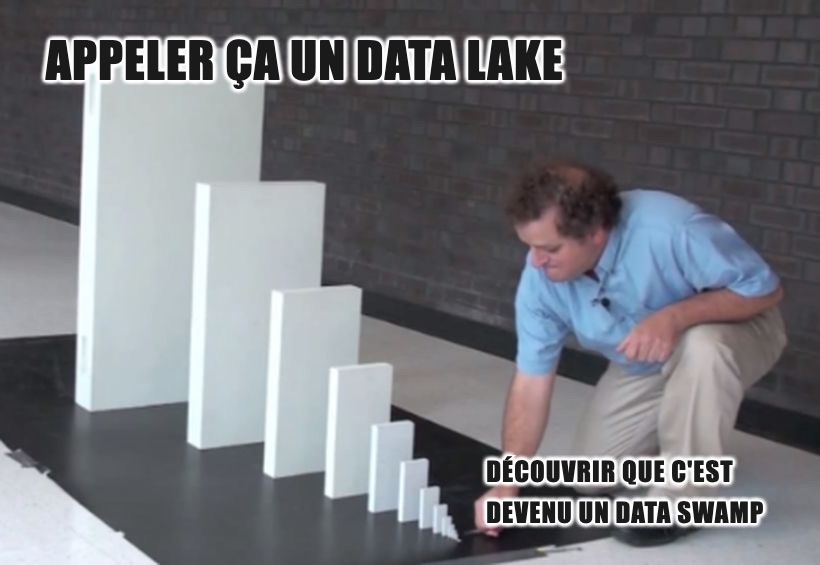

Même si le data lake offre une grande liberté, cette flexibilité peut vite devenir un piège s’il n’est pas cadré. On parle parfois de “data swamp” (marécage de données) lorsque les données s’y accumulent sans documentation, sans contrôle de qualité, ni gouvernance.

Parmi les principaux défis à surveiller :

Le data lake est donc un espace précieux, mais qui doit être pensé avec méthode, sous peine de devenir inutilisable.

.jpg)