Auditer la qualité des données, c’est avant tout vérifier la solidité de ce sur quoi repose la prise de décision. Car des données imprécises, incomplètes ou obsolètes entraînent inévitablement des erreurs d’analyse, des choix discutables et une perte de confiance dans les outils comme dans les équipes. L’audit permet donc de mesurer, objectiver et hiérarchiser les problèmes pour sortir du ressenti et s’appuyer sur des faits.

Il ne s’agit pas seulement d’identifier des anomalies, mais de comprendre leurs causes, leurs impacts et la manière de les corriger durablement. Cet exercice structure la démarche de gouvernance et pose les bases d’un pilotage plus fiable, fondé sur des informations vérifiées et partagées. En somme, c’est une étape incontournable pour transformer la donnée en un actif maîtrisé plutôt qu’en une source d’incertitude.

La donnée est aujourd’hui au cœur de toutes les décisions, mais sa valeur dépend entièrement de sa qualité. Une information fiable permet d’analyser avec justesse, d’anticiper les tendances et d’orienter les actions stratégiques. Dans le cadre d’un audit qualité des données, cette fiabilité devient un enjeu central : une donnée bien gouvernée crée de la confiance, tandis qu’une donnée dégradée introduit des biais invisibles qui fragilisent la performance globale. Les enjeux dépassent donc largement le simple aspect technique : ils touchent à la crédibilité, à la réactivité et à la compétitivité de l’organisation.

Sur le plan opérationnel, la qualité des données garantit la cohérence entre les services et limite les ressaisies, les erreurs de traitement ou les retours clients. Pour les équipes métiers, c’est la condition d’un reporting fiable, d’un ciblage pertinent et d’une exploitation fluide des outils. Du côté du management, elle permet d’avoir une vision claire de la performance réelle, sans distorsion entre les chiffres et la réalité du terrain.

Enfin, la qualité des données constitue un enjeu stratégique, économique et réglementaire majeur. Elle influence la conformité aux exigences légales, la solidité des audits externes et la confiance des partenaires. Dans un environnement où la donnée circule entre systèmes, filiales et pays, mener un audit qualité des données régulier n’est plus un luxe mais un impératif de maîtrise, de conformité et de continuité pour toute organisation qui souhaite tirer pleinement parti de son capital informationnel.

Lorsque la donnée perd en fiabilité, ce ne sont pas seulement les chiffres qui vacillent, mais toute l’organisation qui se fragilise. Les décisions se brouillent, les processus se bloquent et la confiance s’effrite peu à peu. Les impacts de la non-qualité se font sentir à plusieurs niveaux, parfois visibles, souvent insidieux :

En somme, la non-qualité des données n’est pas une simple imperfection technique : c’est un frein stratégique. Elle érode la performance, mine la confiance et met en péril la conformité. Maintenir un haut niveau de qualité n’est donc pas un luxe, mais une condition de pérennité pour toute organisation moderne.

L’audit de qualité des données marque souvent le moment où l’organisation décide de passer d’une gestion réactive à une gestion maîtrisée de sa donnée. Il ne s’agit plus seulement de corriger des anomalies ponctuelles, mais d’évaluer la fiabilité du patrimoine informationnel dans son ensemble. En identifiant les points faibles, les zones de risque et les écarts entre les pratiques et les besoins réels, l’audit établit une base objective sur laquelle bâtir une gouvernance cohérente.

Cette étape permet de relier la donnée aux usages métiers : comprendre quelles informations sont critiques, où elles circulent, qui les manipule et comment elles sont contrôlées. L’audit devient alors un outil de pilotage, qui aide à prioriser les chantiers, définir les responsabilités et choisir les indicateurs de suivi pertinents.

Il agit aussi comme un révélateur culturel. En confrontant les équipes techniques et métiers autour d’un même diagnostic, il favorise la prise de conscience collective et amorce la structuration d’une gouvernance partagée. Auditer la qualité des données n’est pas une fin en soi, mais le point de départ d’une démarche continue visant à instaurer des standards, clarifier les rôles et garantir la fiabilité durable du capital data.

Avant d’évaluer la qualité des données, encore faut-il savoir ce que cela recouvre réellement. Dans le cadre d’un audit qualité des données, cette compréhension préalable est essentielle pour éviter une approche purement technique ou fragmentée. La qualité des données ne se résume pas à l’absence d’erreurs : elle traduit la capacité d’une organisation à produire, maintenir et exploiter des informations fiables, cohérentes et utiles pour la prise de décision.

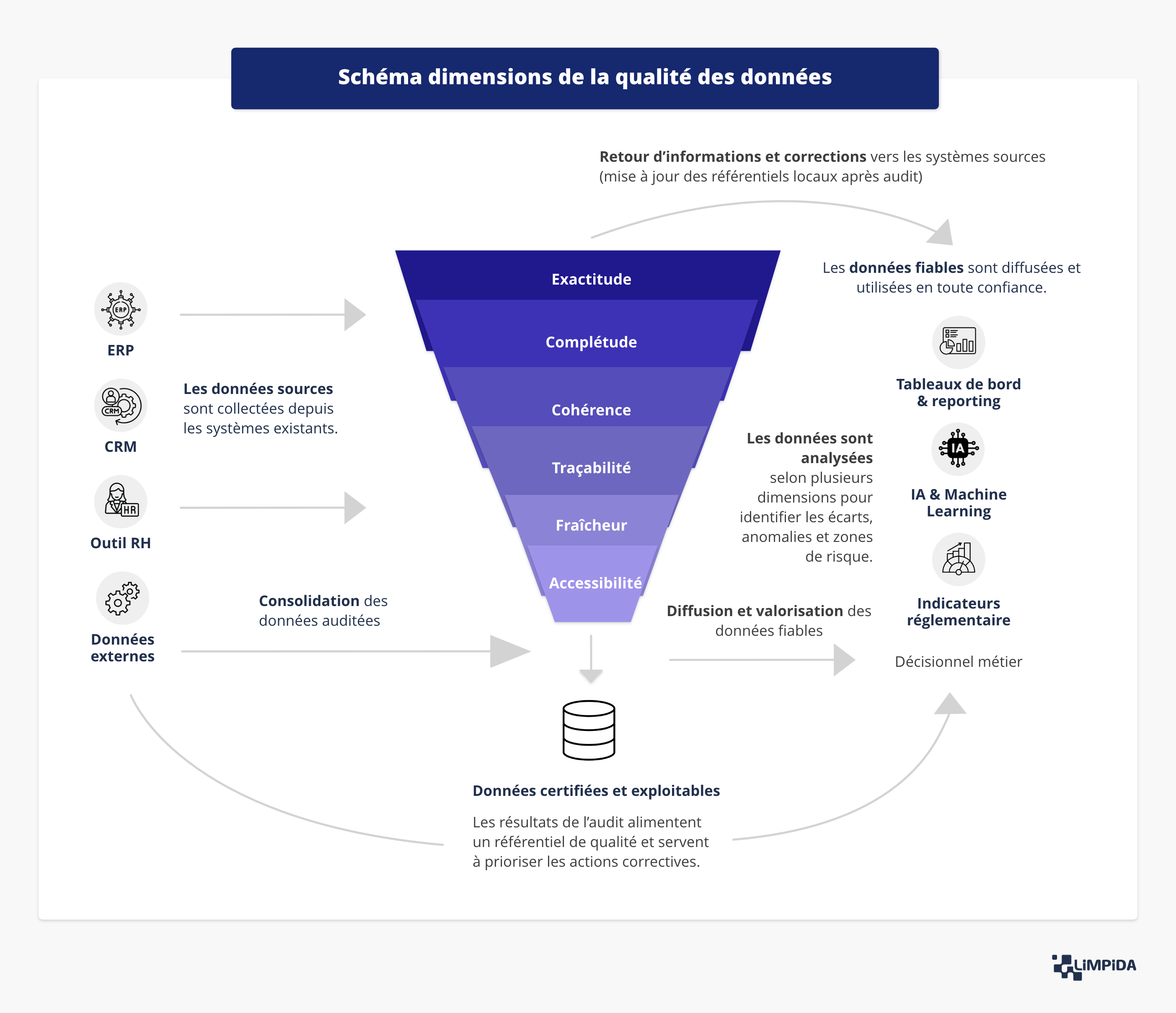

Le schéma ci-dessus illustre ce processus : les données issues des systèmes sources (ERP, CRM, outils RH, données externes) sont consolidées, analysées selon plusieurs dimensions, puis valorisées dans les outils métiers et décisionnels. Cette logique d’audit qualité des données met en évidence le rôle central des contrôles, de la traçabilité et de la standardisation dans la fiabilité du patrimoine informationnel.

Chaque dimension — exactitude, complétude, cohérence, unicité, actualité — permet d’examiner un aspect spécifique de la fiabilité. Ensemble, elles constituent la base d’une évaluation structurée de la qualité des données, garantissant que les informations certifiées en sortie puissent être exploitées en toute confiance, qu’il s’agisse d’un tableau de bord, d’un modèle prédictif ou d’un reporting réglementaire.

Dans tout audit qualité des données, l’exactitude est la première pierre d’une donnée fiable. Elle mesure la correspondance entre la donnée et le fait réel qu’elle décrit — un client, une transaction, un produit ou un stock. Une qualité des données élevée commence ici : une donnée exacte reflète fidèlement la réalité opérationnelle, sans approximation ni distorsion. Dans le schéma, cette dimension intervient dès la consolidation des données, lorsque l’audit confronte les valeurs collectées à leurs sources d’origine. C’est elle qui conditionne la fiabilité des indicateurs, la pertinence des tableaux de bord et la crédibilité des analyses.

La complétude est un pilier essentiel de toute démarche d’audit qualité des données. Elle évalue la présence de toutes les informations nécessaires à l’exploitation d’un jeu de données. Des champs vides, partiellement remplis ou incohérents peuvent fausser un calcul, déséquilibrer une segmentation client ou compromettre un modèle de prévision. Dans un processus d’audit de la qualité des données, la complétude est vérifiée dès la collecte et la consolidation, pour éviter qu’une donnée incomplète ne remonte jusqu’aux outils métiers. Garantir la complétude, c’est assurer la solidité des analyses et la fiabilité de la prise de décision.

La cohérence est au cœur de la qualité des données. Une donnée cohérente conserve le même sens et la même valeur dans tous les systèmes où elle circule. Par exemple, une référence produit doit correspondre à la même catégorie dans l’ERP et dans le CRM. Dans un audit qualité des données, cette dimension est testée à travers l’analyse inter-systèmes, qui détecte les écarts et garantit une interprétation homogène de l’information. La cohérence favorise l’alignement entre processus, équipes et outils — un facteur déterminant pour éviter les divergences dans les reportings et les décisions.

L’unicité vise à éliminer les redondances, un enjeu central pour tout audit de qualité des données. Elle garantit qu’une même information n’existe qu’en un seul exemplaire dans les systèmes. Un doublon client, par exemple, peut entraîner des erreurs de facturation ou fausser les analyses marketing. L’audit permet d’identifier ces doublons au moment de la consolidation et d’en corriger la cause à la source, afin de ne conserver qu’une version de référence. Assurer l’unicité, c’est renforcer la qualité des données tout en optimisant les performances des traitements et la clarté des analyses.

L’actualité — ou fraîcheur — est la dimension qui mesure la capacité d’une donnée à représenter la situation la plus récente. Une information exacte mais obsolète perd toute valeur décisionnelle. Dans le cadre d’un audit qualité des données, cette dimension intervient à la fin du cycle : les corrections et mises à jour issues de l’audit alimentent les systèmes sources pour maintenir la synchronisation des référentiels. Cette boucle de rétroaction continue assure la qualité des données dans le temps, en évitant que les données certifiées ne deviennent obsolètes ou incohérentes.

En combinant ces dimensions, l’audit de qualité des données permet d’obtenir des données certifiées, exploitables et surtout utiles. C’est cette approche structurée qui transforme un diagnostic ponctuel en véritable levier de fiabilité et de performance pour l’organisation.

La qualité des données n’a de sens que si elle est évaluée à l’aune des besoins réels de l’organisation. Une donnée peut être techniquement correcte, mais inutile si elle ne répond pas à un usage métier concret. Adapter les critères de qualité au contexte, c’est donc relier les dimensions d’audit à la réalité opérationnelle, aux processus et aux décisions qu’elles alimentent.

Adapter les critères au contexte métier, c’est finalement faire de la qualité des données un levier d’efficacité plutôt qu’une contrainte. Cela permet de concentrer les efforts là où ils produisent le plus de valeur, tout en maintenant un haut niveau de fiabilité sur ce qui compte vraiment.

Une donnée de qualité n’est pas une fin en soi : c’est un levier essentiel de performance pour toute organisation. Dans le cadre d’un audit qualité des données, elle se révèle être bien plus qu’une mesure technique — c’est un véritable facteur de compétitivité. Lorsqu’elle est fiable, complète et à jour, la donnée alimente des analyses précises, des prévisions réalistes et des décisions mieux orientées. La qualité des données se traduit donc directement par une meilleure compréhension des clients, une optimisation des processus internes et une réduction des coûts liés aux erreurs, doublons ou inefficiences. À l’inverse, une donnée erronée ou incomplète peut fausser le pilotage, provoquer de mauvais arbitrages ou générer des retards opérationnels coûteux.

La qualité des données soutient également la performance à travers la confiance qu’elle instaure dans les outils de pilotage. Un tableau de bord ou un reporting n’a de valeur que si les chiffres qu’il affiche reflètent fidèlement la réalité du terrain. En fiabilisant la donnée grâce à un audit qualité des données rigoureux, l’entreprise renforce la crédibilité de ses indicateurs et favorise une prise de décision rapide et éclairée, fondée sur des faits plutôt que sur des intuitions. La donnée devient alors un socle de vérité partagée entre les métiers, l’IT et la direction.

Enfin, une donnée de qualité crée un environnement propice à l’innovation et à la transformation numérique. Elle facilite l’automatisation, les analyses avancées et les projets d’intelligence artificielle — autant d’initiatives qui reposent sur la fiabilité du socle d’information. Une stratégie de qualité des données bien pilotée n’est donc pas un simple gage de conformité : c’est un facteur de performance durable et un pilier de croissance. L’audit qualité des données devient alors le point de départ d’un cercle vertueux, où la donnée, maîtrisée et valorisée, se transforme en actif stratégique au service de la compétitivité de l’entreprise.

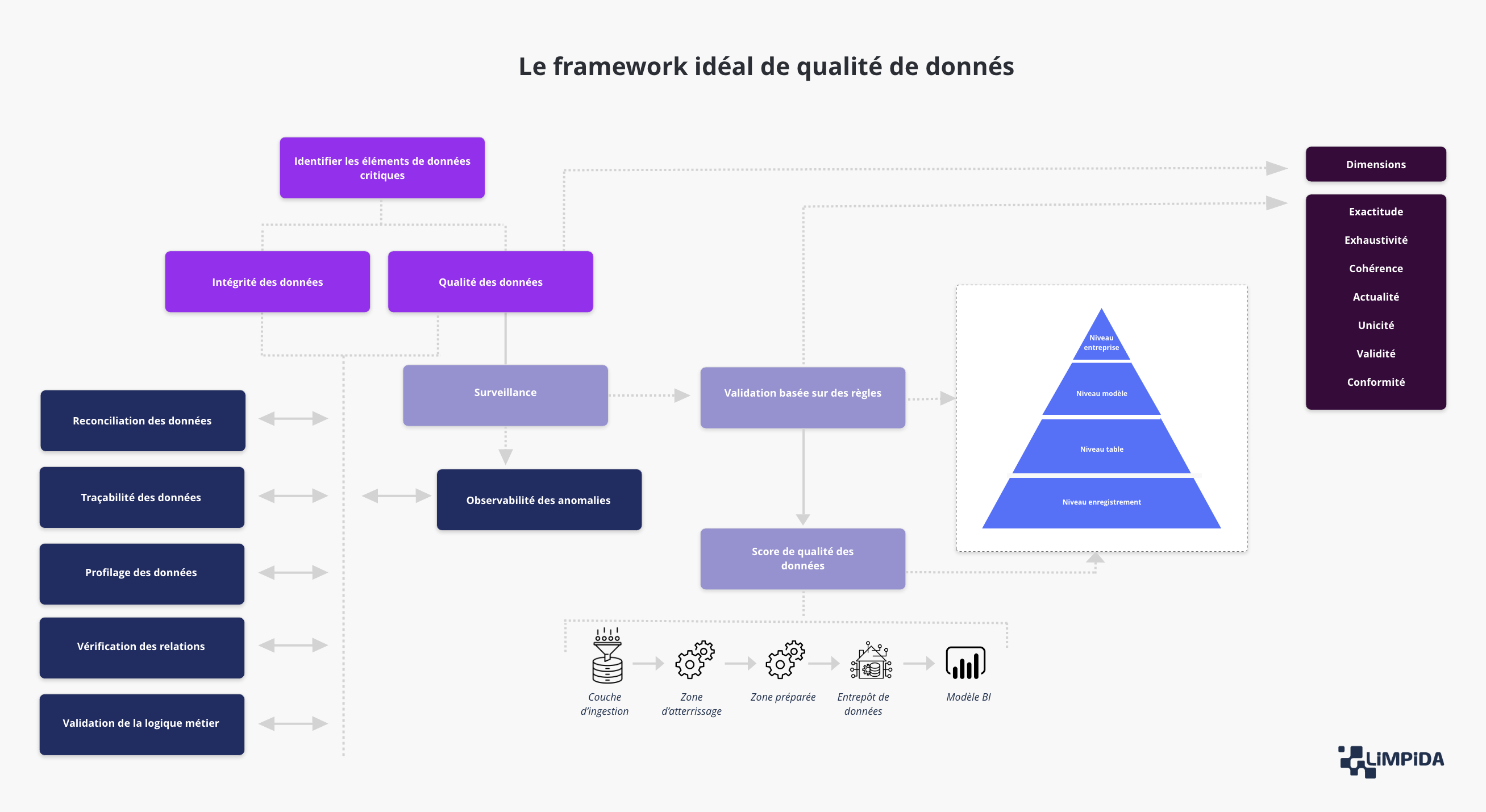

Voici ce à quoi devrait ressembler un framework idéal de la qualité des données : une démarche claire, structurée et continue, qui transforme la gestion des anomalies en véritable levier de confiance et d’efficacité. L’idée n’est pas d’ajouter une couche de contrôle bureaucratique, mais d’organiser intelligemment les étapes pour que la donnée soit fiable avant même d’être exploitée.

Tout commence par l’identification des éléments de données critiques. Avant de vouloir tout contrôler, il faut savoir ce qui compte vraiment. Certaines données sont stratégiques, d’autres simplement utiles — et l’audit ne doit pas les traiter de la même manière. C’est cette hiérarchisation qui permet d’allouer les efforts là où ils apportent le plus de valeur et d’éviter de perdre du temps à corriger des détails sans impact.

Vient ensuite l’intégrité des données, le socle de tout framework solide. Ici, on s’assure que les données sont complètes, cohérentes et bien structurées avant d’être utilisées. Cela passe par des opérations concrètes : réconciliation entre systèmes, traçabilité des flux, profilage statistique, vérification des relations entre tables et validation des règles métiers. En clair, on ne fait pas confiance aux chiffres “sur parole”, on les confronte aux faits.

Puis intervient le volet surveillance, véritable système nerveux du dispositif. Grâce à la collecte automatique d’indicateurs et à l’observabilité des anomalies, il devient possible de détecter les dérives en temps réel, de comprendre leur origine et d’anticiper les incidents avant qu’ils n’impactent les utilisateurs. Ce n’est plus un audit ponctuel, c’est une boucle de contrôle permanente.

Ces éléments alimentent la validation basée sur des règles, où la donnée est testée selon des critères précis : format, valeur, dépendance logique ou seuil critique. À ce stade, l’organisation peut calculer un score de qualité des données, véritable thermomètre de fiabilité. Il permet de mesurer la progression dans le temps, de communiquer clairement les résultats et de rendre la qualité des données enfin tangible pour tous.

Enfin, ce framework s’intègre à chaque étape du cycle de vie de la donnée — de la couche d’ingestion à la zone d’atterrissage, puis jusqu’à l’entrepôt et au modèle BI. Chaque couche joue un rôle spécifique dans la construction d’une donnée certifiée, traçable et exploitable.

Ce framework n’a rien de théorique : c’est une méthode pragmatique, conçue pour que la qualité des données ne soit plus un sujet à part, mais un réflexe collectif. Un moyen concret d’assurer que ce qui alimente vos tableaux de bord, vos IA ou vos décisions stratégiques repose enfin sur un socle solide — bref, sur de la donnée en laquelle on peut vraiment avoir confiance.

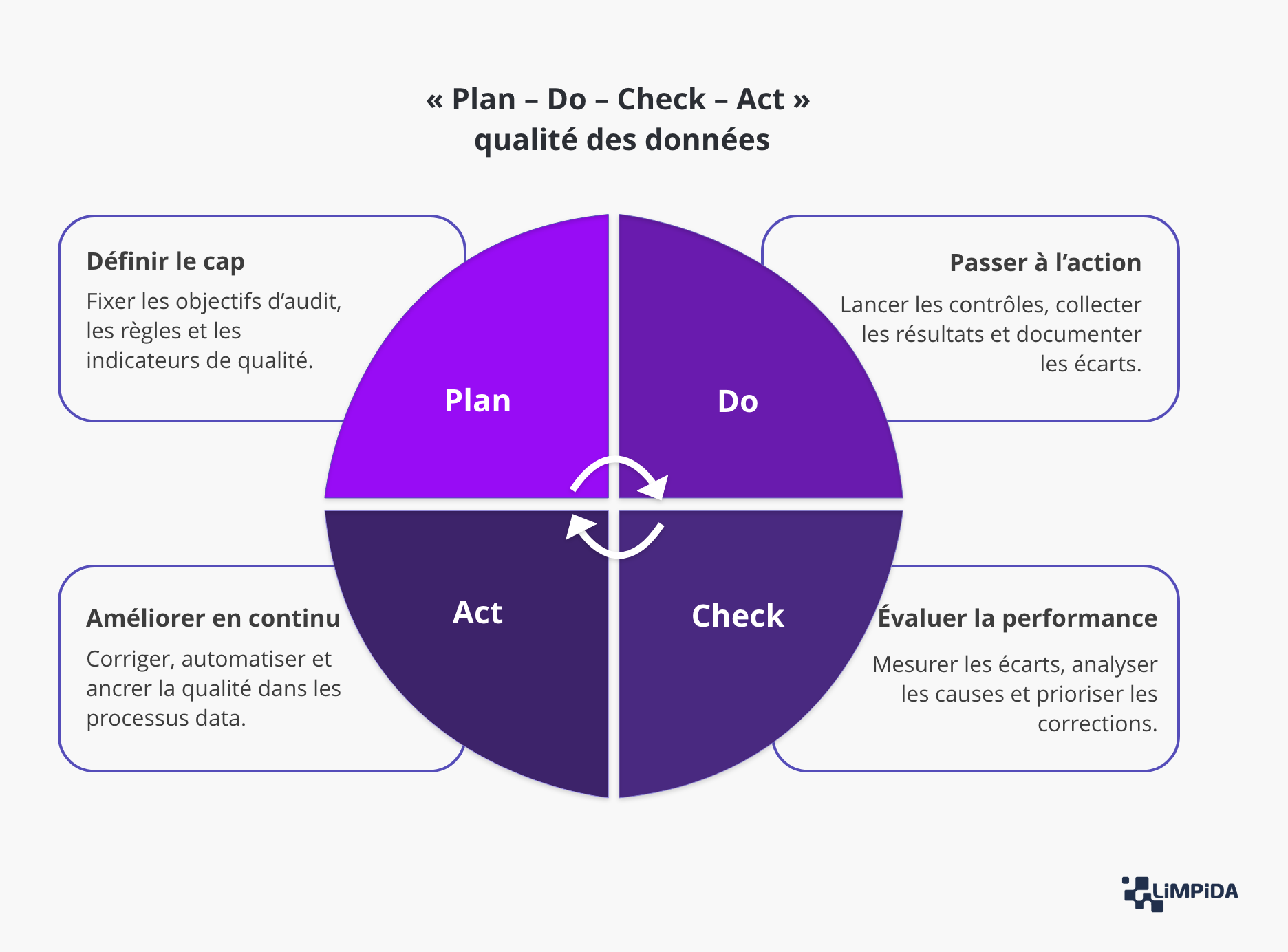

Avant de plonger dans la méthodologie d’audit, il est essentiel de comprendre que la qualité des données n’est pas un exercice ponctuel, mais un cycle d’amélioration continue. Le modèle Plan – Do – Check – Act (PDCA), largement utilisé dans les démarches qualité, s’applique parfaitement à la gestion des données. Il permet de structurer les actions, d’éviter les initiatives isolées et d’instaurer une dynamique durable de progression.

Le principe est simple : on planifie, on agit, on vérifie, puis on améliore. Ce cycle s’enchaîne en continu, chaque itération renforçant la fiabilité du patrimoine data.

Ce schéma ne décrit pas un processus figé, mais une démarche vivante, adaptée à la maturité de chaque organisation. Il offre une boussole simple et efficace pour piloter la qualité des données de manière pragmatique, mesurable et évolutive.

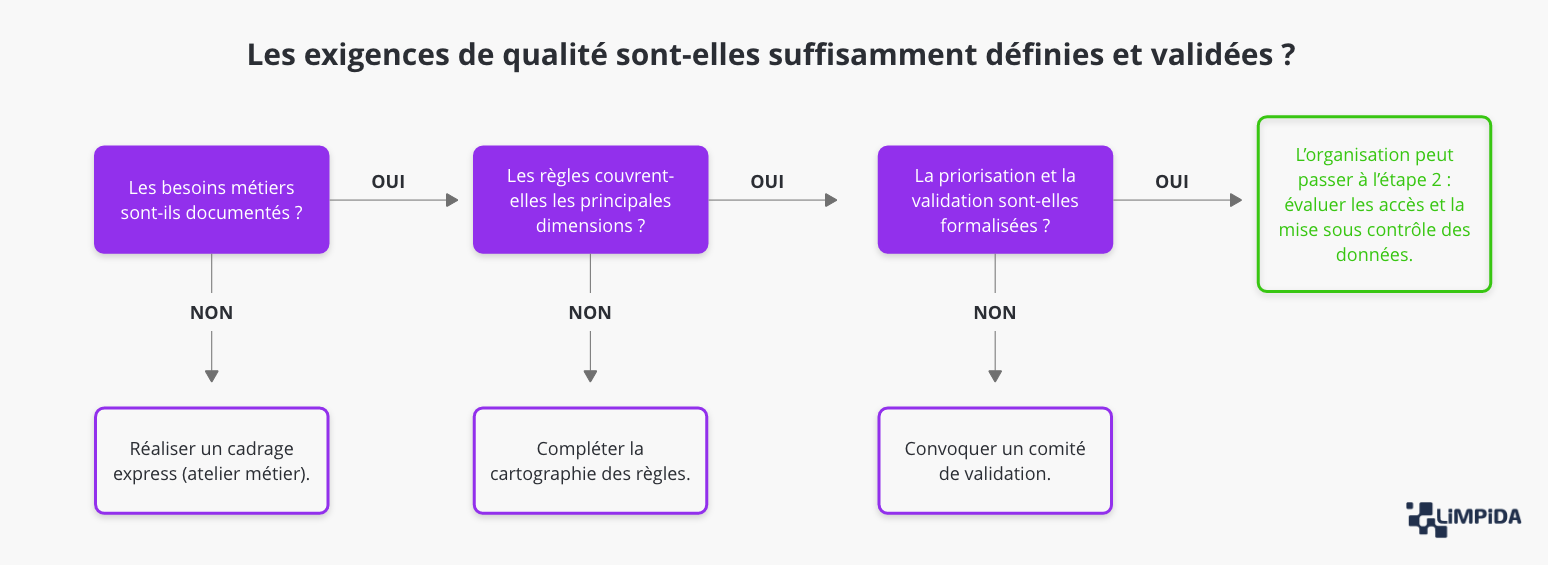

Avant de juger la qualité d’un jeu de données, encore faut-il savoir ce qu’on attend de lui. Cette première étape pose les fondations de l’audit : elle fixe les objectifs, structure les attentes et crée un langage commun entre métiers et techniques. C’est là que se joue la différence entre une démarche maîtrisée et un audit superficiel.

L’audit doit commencer par la compréhension des besoins métiers. Sans cette étape, on risque de mesurer des éléments sans importance réelle. Il s’agit ici d’identifier ce qui compte vraiment, et non ce qui est le plus simple à contrôler.

Points à approfondir :

Une donnée peut être correcte sur le plan syntaxique et pourtant inexploitée car elle manque de cohérence ou d’actualité. Cette étape vise à vérifier que toutes les dimensions de la qualité pertinentes pour le contexte sont effectivement couvertes et mesurées.

Ce que l’audit doit vérifier en détail :

Toutes les données ne se valent pas : certaines erreurs ont un impact limité, d’autres peuvent remettre en cause une décision ou une conformité. L’audit évalue donc la capacité de l’organisation à hiérarchiser ses exigences de qualité selon leur importance réelle.

Éléments d’analyse à développer :

La dernière étape de cette phase consiste à s’assurer que les exigences définies ne sont pas simplement théoriques, mais bien validées, tracées et gouvernées. Sans validation formelle, aucune règle ne peut servir de base à un audit fiable.

Critères d’évaluation détaillés :

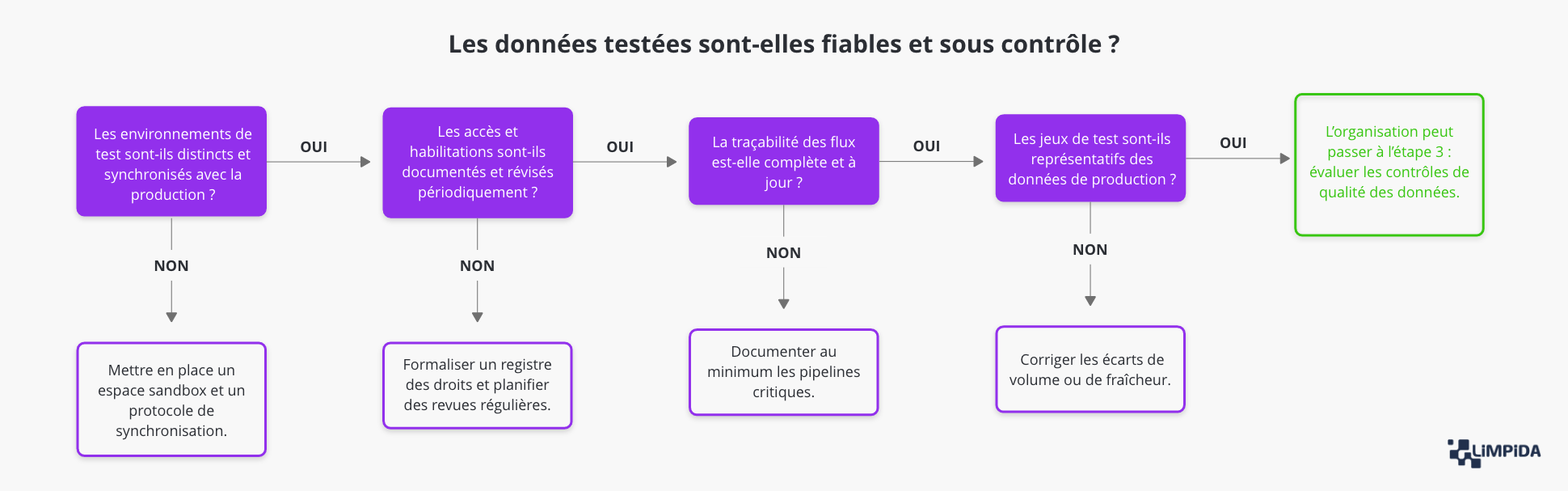

Une fois les exigences définies, encore faut-il pouvoir les vérifier. Cette étape vise à s’assurer que les données utilisées pour les contrôles de qualité sont accessibles, traçables, sécurisées et représentatives de la production. C’est souvent là que la différence entre une démarche théorique et une pratique maîtrisée devient visible.

Trop d’organisations disposent de règles de qualité bien conçues sur le papier, mais impossibles à appliquer faute d’environnements fiables, synchronisés ou correctement documentés. Or, sans contrôle de l’accès aux données, aucun résultat d’audit n’a de valeur. Évaluer cette dimension revient donc à mesurer le degré de maîtrise technique de l’organisation et la maturité opérationnelle de sa gouvernance.

Avant d’exécuter le moindre contrôle, l’auditeur doit s’assurer que l’entreprise dispose d’un environnement distinct de la production, dédié à la vérification de la qualité des données. Cet environnement constitue le socle technique de toute démarche fiable.

Points d’analyse détaillés :

Tester la qualité des données implique de manipuler des informations souvent sensibles : données personnelles, contrats, indicateurs financiers, etc. L’audit doit donc s’assurer que l’accès à ces données est strictement encadré et conforme aux règles de sécurité et de confidentialité.

Éléments à examiner de près :

La traçabilité constitue la mémoire technique du système : elle permet de retracer le parcours complet d’une donnée, depuis sa source initiale jusqu’à son exploitation en environnement de test. Sans cette transparence, il est impossible d’expliquer ni de corriger une anomalie.

Ce que l’audit doit analyser :

Enfin, les données sur lesquelles reposent les tests doivent être représentatives de la réalité de la production. Un audit mené sur des données partielles, obsolètes ou échantillonnées sans méthode rigoureuse n’aura qu’une valeur indicative.

Points de contrôle détaillés :

C’est à cette étape que l’audit devient véritablement opérationnel. Après avoir défini les exigences et vérifié les environnements, il s’agit maintenant d’évaluer l’efficacité réelle des contrôles de qualité : sont-ils bien en place, correctement paramétrés, automatisés et compris par les équipes ?

Une organisation peut disposer des meilleures intentions sur le papier, mais si les contrôles sont partiels, manuels ou mal interprétés, la fiabilité de la donnée reste illusoire. Cette phase permet donc de mesurer la solidité du dispositif en conditions réelles — autrement dit, de confronter la gouvernance aux faits.

Avant toute analyse, l’auditeur doit établir une cartographie précise des contrôles existants. L’objectif est de comprendre ce qui est effectivement mesuré, sur quels périmètres, et selon quelle logique. Une couverture bien définie évite à la fois les angles morts et les doublons.

Ce que l’audit doit examiner :

Un contrôle de qualité efficace est un contrôle régulier. L’auditeur doit donc s’assurer que les tests sont intégrés dans les processus opérationnels, automatisés quand cela est pertinent, et accompagnés d’un suivi en cas d’échec.

Éléments à approfondir :

La pertinence des seuils conditionne la crédibilité du dispositif de contrôle. Des seuils trop stricts déclenchent des alertes inutiles ; des seuils trop permissifs laissent passer les anomalies. L’enjeu est donc de trouver un équilibre entre rigueur technique et pragmatisme métier.

Critères d’évaluation détaillés :

Un dispositif de contrôle efficace ne se limite pas à la détection d’anomalies : il doit permettre leur compréhension, leur priorisation et leur suivi. Cette dernière sous-étape évalue donc la manière dont les résultats sont restitués et exploités par les équipes.

Points de contrôle approfondis :

Cette étape, souvent la plus technique de l’audit, permet de vérifier si le dispositif de contrôle de qualité est vivant, automatisé et exploitable. En d’autres termes, si la qualité des données n’est pas seulement mesurée, mais réellement pilotée.

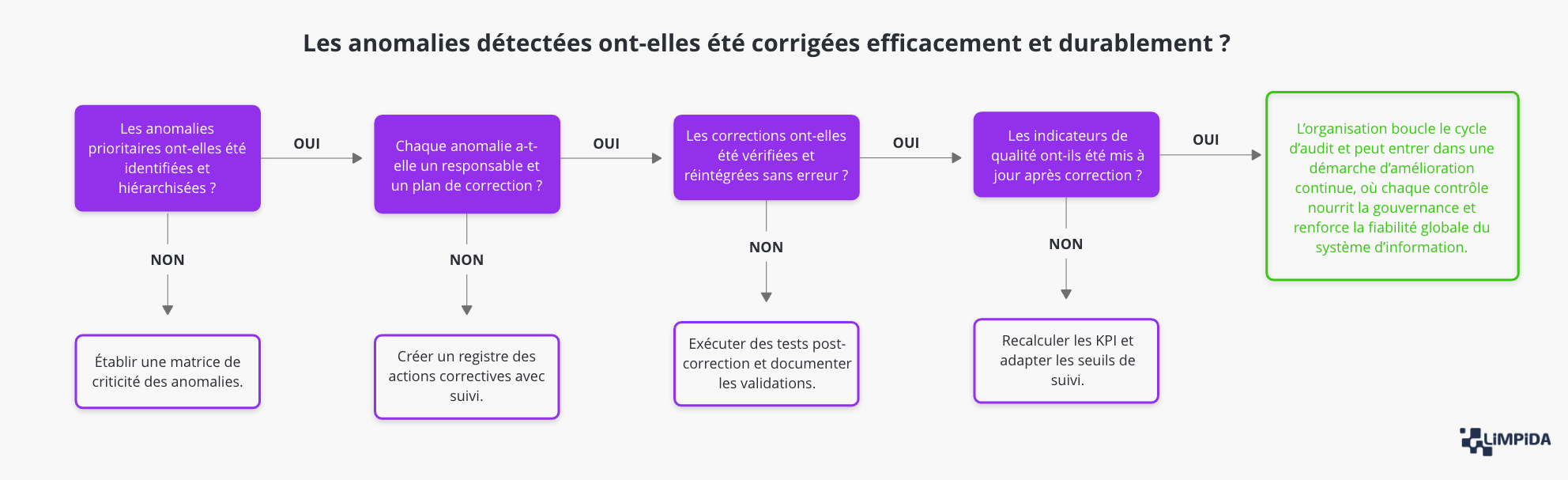

Un audit de la qualité des données n’a de valeur que s’il débouche sur des actions concrètes. Identifier les anomalies sans les comprendre ni les corriger reviendrait à faire un diagnostic sans traitement. Cette dernière étape transforme donc les constats en décisions, les décisions en corrections, et les corrections en amélioration durable.

L’objectif n’est pas seulement de “nettoyer” les données, mais de créer un mécanisme d’apprentissage : chaque anomalie devient une opportunité d’améliorer les processus, la gouvernance et la culture data.

Une fois les contrôles exécutés, il faut trier les anomalies, car toutes n’ont pas le même poids. Certaines sont anecdotiques, d’autres compromettent la conformité, la performance ou la fiabilité des analyses.

Ce que l’audit doit examiner :

Identifier les erreurs ne suffit pas : encore faut-il qu’elles soient prises en charge par les bonnes personnes, dans des délais réalistes et avec une traçabilité complète. Cette étape mesure la capacité de l’organisation à transformer les anomalies en plan d’action concret.

Points de contrôle à approfondir :

Corriger une erreur ne suffit pas : encore faut-il vérifier que la correction est techniquement solide, durable et bien réintégrée dans les flux de production. Une correction mal appliquée peut créer de nouvelles incohérences.

Éléments d’audit détaillés :

Un audit n’a d’intérêt que s’il permet de mesurer les progrès accomplis. Cette dernière sous-étape consiste à évaluer l’impact des actions correctives sur les indicateurs de qualité et à adapter le dispositif en conséquence.

Ce qu’il faut mesurer et suivre :

L’exploitation des résultats est l’étape qui donne tout son sens à l’audit. Elle transforme la détection d’erreurs en démarche d’apprentissage collectif et inscrit la qualité dans une logique durable d’amélioration continue.

Il est impossible de piloter ce que l’on ne mesure pas. L’audit qualité des données ne fait pas exception à cette règle : sans indicateurs fiables, la qualité des données reste une perception, rarement une réalité objectivée. Mesurer pour comprendre, comprendre pour agir : c’est ainsi que l’organisation passe d’un ressenti à une maîtrise, d’une intuition à une décision éclairée.

Un programme de qualité des données ne se limite pas à corriger des erreurs ; il vise à instaurer une boucle de pilotage continue. Les indicateurs jouent ici un rôle central : ils permettent de détecter les dérives, de suivre les progrès et de démontrer la valeur du travail accompli. Sans eux, la gouvernance de la donnée reste un concept théorique, incapable de prouver son efficacité ou de justifier les efforts entrepris.

Mais au-delà de la simple mesure, ces indicateurs constituent un langage commun entre les équipes. Le Data Steward y voit un outil de suivi opérationnel, le Data Quality Manager un tableau de bord de performance, et le CDO un instrument de pilotage stratégique. Grâce à ces repères, l’entreprise peut aligner les objectifs métiers et techniques autour d’une vision partagée de la fiabilité et de la performance data.

Enfin, mesurer la qualité des données permet aussi de quantifier la valeur économique de la donnée. Un taux d’erreurs réduit, un temps de correction plus court ou une meilleure cohérence inter-systèmes se traduisent directement par des gains de productivité, de conformité et de confiance. Les KPI issus d’un audit qualité des données deviennent alors des leviers d’amélioration continue, bien plus que de simples outils de reporting.

Ainsi, mesurer la qualité des données, c’est transformer un sujet souvent abstrait en pilotage concret et mesurable. Sans indicateurs, la donnée reste une matière première ; avec eux, elle devient un actif stratégique, mesurable et durable, au cœur de la performance et de la gouvernance de l’entreprise.

Le taux de complétude mesure la part de données effectivement renseignées par rapport au total attendu. C’est un indicateur fondamental pour évaluer la fiabilité d’un ensemble de données et son exploitabilité réelle. Une base peut paraître volumineuse, mais si des champs essentiels — tels qu’un identifiant client, un code produit ou une date de transaction — sont manquants, elle perd instantanément de sa valeur. Cet indicateur aide donc à identifier les domaines où la collecte d’information est insuffisante ou inconstante, et permet de cibler les actions correctives à mener. En suivant son évolution dans le temps, l’organisation peut mesurer l’efficacité de ses processus de saisie et de mise à jour.

Le taux d’erreurs traduit la proportion de données jugées incorrectes au regard des règles de qualité définies. Ces erreurs peuvent provenir d’une mauvaise saisie, d’une incohérence entre systèmes ou encore d’une transformation erronée dans les pipelines de traitement. Cet indicateur permet d’apprécier la robustesse des processus de contrôle, mais aussi la rigueur avec laquelle les données sont produites et maintenues. Un taux d’erreurs élevé n’est pas nécessairement négatif : il peut témoigner d’une meilleure détection ou d’une montée en vigilance. L’enjeu est de comprendre les causes profondes des anomalies pour agir sur les processus plutôt que sur les symptômes.

Ce KPI évalue la capacité d’une organisation à traiter les anomalies détectées et à les résoudre de manière durable. Il ne s’agit plus ici de constater un problème, mais de mesurer la réactivité et l’efficacité du dispositif de correction. Un taux de correction élevé traduit un système bien piloté, où les erreurs identifiées sont suivies, assignées et corrigées dans des délais maîtrisés. À l’inverse, un taux faible signale un décalage entre la détection et l’action, souvent lié à une mauvaise coordination entre les équipes métiers et techniques. Suivre ce taux dans le temps permet de mesurer la progression de la maturité opérationnelle de l’organisation.

Le taux de cohérence évalue le degré d’alignement des données entre plusieurs systèmes ou référentiels. Une donnée cohérente conserve la même valeur et le même sens, quel que soit le point d’entrée où elle est consultée. Cet indicateur est particulièrement pertinent dans les environnements complexes où la donnée circule entre différentes applications — CRM, ERP, outils analytiques, plateformes cloud, etc. Un faible taux de cohérence révèle souvent des défauts d’intégration, des doublons ou des logiques de transformation divergentes. En mesurant régulièrement cet indicateur, l’organisation peut identifier les zones de friction et renforcer la fiabilité de son écosystème data.

Le délai moyen de correction indique le temps nécessaire pour qu’une anomalie détectée soit effectivement corrigée et validée. Il reflète la réactivité opérationnelle et la fluidité du processus de gouvernance des données. Un délai court est le signe d’une bonne coordination entre les équipes, d’une priorisation claire et de procédures bien établies. À l’inverse, un délai trop long peut signaler des blocages techniques, un manque de ressources ou une gouvernance encore trop fragmentée. En suivant cet indicateur, les organisations peuvent identifier les points de ralentissement et améliorer la performance de leur dispositif de correction.

Un tableau de bord de qualité des données ne doit pas se limiter à une série de graphiques : c’est un véritable outil de pilotage qui permet de suivre les performances, d’identifier les anomalies et d’orienter les décisions. Bien conçu, il réunit les métiers et la data autour d’une même lecture de la réalité.

Pour être utile, il doit combiner trois caractéristiques : la clarté, la pertinence et l’évolutivité.

Avant même de penser visualisation, il faut fixer les règles du jeu : à partir de quand une donnée est-elle considérée comme “à risque” ? Les seuils constituent la base du pilotage. Ils permettent de distinguer un écart tolérable d’une anomalie critique.

Les seuils constituent la base d’un suivi pertinent : ils transforment la mesure brute en information exploitable. Pour qu’ils aient du sens, ils doivent avant tout être alignés avec la réalité métier. Leur définition ne peut pas reposer uniquement sur des considérations techniques ; elle doit traduire un impact concret sur les processus ou les décisions. Il est donc essentiel de les définir en concertation avec les métiers, afin de distinguer ce qui relève d’une simple alerte de ce qui représente un risque opérationnel. Chaque seuil doit être documenté avec précision — sa source, sa méthode de calcul, sa fréquence de mise à jour — pour garantir la transparence et la continuité dans le temps. Enfin, la mise en place d’un système d’alerte automatique, visuel ou par notification, permet de déclencher rapidement les actions correctives et d’éviter que des dérives passent inaperçues.

Un tableau de bord efficace doit être compris sans traduction technique. L’objectif n’est pas de montrer la complexité du système, mais de faciliter la décision.

Les visualisations doivent hiérarchiser l’information et guider l’interprétation : un bon design raconte une histoire claire sur l’état de la qualité des données.

Quelques repères visuels recommandés :

La conception d’un tableau de bord de qualité des données repose sur un équilibre délicat entre exhaustivité et lisibilité. Un tableau surchargé devient illisible, tandis qu’un tableau trop épuré manque de substance. Il est donc recommandé de limiter le nombre d’indicateurs visibles à huit par vue, afin de concentrer l’attention sur les plus stratégiques. L’esthétique joue également un rôle clé : des couleurs cohérentes et contrastées facilitent la lecture et évitent la confusion, surtout lorsque plusieurs sources ou systèmes sont comparés. Enfin, l’ergonomie doit favoriser l’autonomie des utilisateurs métiers. Des filtres dynamiques et intuitifs leur permettent de naviguer librement entre domaines, périodes ou sources de données sans recourir à une assistance technique, renforçant ainsi la dimension self-service du pilotage de la qualité.

Un tableau de bord n’est pas figé. À mesure que la gouvernance se structure et que la culture data se diffuse, les indicateurs doivent évoluer pour refléter une vision plus fine et plus stratégique.

Étapes d’évolution possibles :

Pour accompagner cette évolution :

À mesure que la maturité data progresse, le tableau de bord doit évoluer pour rester pertinent. Les indicateurs choisis au départ peuvent devenir obsolètes si les processus ou les priorités changent. Organiser des revues trimestrielles permet d’ajuster les KPI et de s’assurer qu’ils continuent à refléter la réalité du terrain. L’introduction de métriques prédictives, comme la détection des tendances d’erreurs ou le calcul du temps moyen avant dérive, aide à anticiper les problèmes plutôt qu’à les constater a posteriori. Enfin, relier les KPI de qualité à des indicateurs métiers tels que le chiffre d’affaires, la satisfaction client ou la conformité réglementaire ancre la démarche dans une logique de performance globale. La qualité des données cesse alors d’être un enjeu isolé pour devenir un levier tangible de création de valeur.

En combinant des seuils clairs, des visualisations compréhensibles et des indicateurs évolutifs, le tableau de bord devient bien plus qu’un outil de suivi. Il devient le centre de gravité de la gouvernance de la donnée, capable de transformer les chiffres en décisions et les constats en actions.

Un audit de qualité des données n’a de sens que s’il s’inscrit dans la continuité. Trop souvent perçu comme un exercice ponctuel, il doit au contraire devenir un processus vivant, intégré au fonctionnement quotidien de l’organisation. La qualité des données ne se décrète pas une fois pour toutes : elle se cultive, s’entretient et se mesure régulièrement. Pour qu’une démarche d’audit ait un impact durable, elle doit être traduite en pratiques concrètes, connectées à la réalité des métiers et soutenues par une gouvernance solide.

La première condition pour faire vivre la démarche consiste à ancrer la qualité dans les opérations quotidiennes. Chaque processus métier – qu’il s’agisse de la relation client, de la gestion des stocks ou du reporting financier – doit inclure un moment de vérification ou de validation des données manipulées. Dans une logique d’audit qualité des données, l’objectif n’est plus seulement de corriger a posteriori, mais d’éviter l’apparition même des erreurs en amont. Cela suppose une responsabilisation accrue des équipes : la qualité devient une composante naturelle de leur travail, et non une contrainte imposée de l’extérieur.

Concrètement, cela passe par des contrôles intégrés dans les outils métiers, des règles de validation automatisées dans les formulaires ou encore des tableaux de bord accessibles à tous. En formant les collaborateurs à l’impact de la donnée sur leur activité, on transforme la perception de la qualité des données : elle cesse d’être un sujet technique pour devenir un réflexe collectif et durable, au service de la performance et de la fiabilité organisationnelle.

La qualité des données repose sur une organisation claire, où chacun connaît son rôle et ses responsabilités. C’est là qu’intervient la gouvernance de la donnée, qui définit les règles, les acteurs et les processus nécessaires pour assurer la cohérence, la sécurité et la fiabilité du patrimoine informationnel. Dans le cadre d’un audit qualité des données, cette gouvernance devient essentielle : elle permet de structurer les pratiques, d’harmoniser les contrôles et de garantir la traçabilité des actions. Une gouvernance efficace s’appuie sur trois piliers indissociables : la définition des rôles, le fonctionnement du Data Office et la mise en place de comités de pilotage qualité.

Elle permet de maintenir une cohérence durable entre les actions techniques et les priorités métiers, en alignant nettoyage, contrôles et monitoring sur les objectifs de fiabilité des indicateurs, de conformité et de performance opérationnelle. Grâce à cette approche, la qualité des données devient un levier de performance collective, soutenu par une organisation claire et des responsabilités bien établies. L’enjeu est d’instaurer un modèle durable, où la qualité n’est plus un projet ponctuel mais un cadre permanent, intégré à la stratégie globale et renforcé à chaque audit qualité des données.

Le Data Steward est le gardien opérationnel de la donnée. Il veille à sa cohérence, documente les règles de gestion et agit comme relais entre les métiers et les équipes techniques. Son rôle est de s’assurer que la donnée est bien comprise, bien utilisée et conforme aux standards définis.

Le Data Quality Manager, quant à lui, pilote le dispositif global de qualité : il définit les contrôles, mesure les indicateurs et coordonne les actions correctives. Il garantit la fiabilité des données sur le long terme et anime la démarche d’amélioration continue.

Enfin, le Chief Data Officer (CDO) incarne la vision stratégique. Il définit la politique de gouvernance, arbitre les priorités et veille à ce que la donnée serve les objectifs globaux de l’entreprise. Ensemble, ces trois acteurs forment le socle humain de la gouvernance, combinant vision, pilotage et exécution

Le Data Office est la structure qui orchestré la gouvernance de la donnée et veille à la cohérence globale du dispositif de qualité des données. Il réunit les rôles clés — CDO, Data Steward, Data Quality Manager et Data Architect — et assure la coordination entre les équipes métiers, IT et conformité. Son rôle ne se limite pas à la supervision : il harmonise les pratiques, définit les référentiels, outille la démarche et s’assure que chaque acteur dispose des moyens nécessaires pour garantir un haut niveau de qualité des données. Le Data Office agit comme un centre de gravité, où les décisions stratégiques sur la gestion de la donnée se traduisent en actions concrètes et mesurables.

Les comités qualité complètent ce dispositif en jouant un rôle de supervision et d’arbitrage. Ils analysent les résultats issus de l’audit qualité des données, priorisent les actions correctives et valident les évolutions des règles de qualité. Ces comités constituent un espace de dialogue entre les métiers et les équipes data, où les décisions se fondent sur des faits mesurés plutôt que sur des perceptions. Leur régularité — mensuelle ou trimestrielle selon la maturité — permet de maintenir une dynamique d’amélioration continue et d’éviter la résurgence d’anomalies anciennes.

En articulant ainsi un Data Office structuré et des comités qualité actifs, l’organisation met en place un cadre de pilotage solide, garantissant que la qualité des données reste une priorité constante et partagée. Ce fonctionnement intégré transforme l’audit qualité des données en un levier durable de gouvernance, assurant la fiabilité, la traçabilité et la performance du patrimoine informationnel de l’entreprise.

Chaque audit produit une quantité précieuse d’informations : anomalies détectées, causes identifiées, correctifs mis en œuvre, et résultats obtenus. Plutôt que de repartir de zéro à chaque campagne, il est indispensable de capitaliser sur ces enseignements.

Une bonne pratique consiste à formaliser un registre d’audit, regroupant l’ensemble des constats et des plans d’action associés. Ce registre permet d’analyser les tendances dans le temps, de repérer les domaines les plus instables et d’éviter la répétition des mêmes erreurs.

Exemples de leviers de capitalisation :

En procédant ainsi, l’audit devient un véritable outil d’apprentissage collectif, et non une simple vérification administrative.

L’amélioration continue suppose de pouvoir mesurer les progrès réalisés. Cela implique d’évaluer régulièrement la maturité de l’organisation en matière de qualité et de gouvernance des données.

Cette évaluation peut s’appuyer sur un référentiel interne ou sur des modèles reconnus (comme le Data Management Maturity Model - DMMM). L’idée n’est pas de viser la perfection, mais de disposer d’un cadre d’auto-évaluation qui met en lumière les forces et les points à renforcer.

Ce suivi dans le temps permet de démontrer la valeur de la démarche et de justifier les investissements réalisés dans la gouvernance et les outils de qualité.

La qualité des données doit être visible, partagée et comprise pour devenir un réflexe collectif. Trop souvent, les résultats d’audit restent confinés aux équipes data, alors qu’ils peuvent servir d’outil de sensibilisation puissant auprès des métiers.

La communication est donc un levier central de l’amélioration continue. Elle permet non seulement de valoriser les progrès accomplis, mais aussi de maintenir la mobilisation des équipes.

Quelques approches efficaces :

En instaurant une communication claire et régulière, l’organisation transforme la qualité des données en un enjeu collectif et fédérateur, intégré à la culture d’entreprise.

Ainsi, chaque audit devient non pas une contrainte, mais une opportunité d’apprentissage et de progrès partagé.

L’audit de qualité des données n’est pas une fin en soi, mais le point de départ d’une transformation profonde. Ce n’est pas un simple exercice d’évaluation, mais un moment de lucidité : celui où l’organisation confronte ses pratiques à la réalité, identifie ses failles, mais aussi ses forces. L’enjeu n’est pas de produire un score flatteur, mais de créer les conditions d’une amélioration durable. L’audit devient ainsi la première pierre d’une gouvernance data vivante, structurée et orientée résultats.

Un audit réussi ne s’arrête pas au constat : il débouche sur une mise en mouvement. Les conclusions tirées doivent alimenter un véritable plan d’action, intégrant la qualité des données au cœur des processus existants. Les meilleures organisations ne créent pas de contrôles parallèles, elles injectent la qualité là où la donnée naît : dans les outils métiers, les formulaires, les flux d’intégration ou les rapports décisionnels.

En pratique, cela suppose d’institutionnaliser la qualité : définir des règles de cohérence applicables dès la saisie, automatiser les vérifications dans les pipelines de données, et suivre les écarts dans les mêmes circuits que les incidents métiers. Cette intégration fluide permet de passer d’une démarche ponctuelle à une gouvernance durable, où la qualité devient un réflexe quotidien.

La donnée n’a de valeur que si elle est maîtrisée. Et cette maîtrise ne vient pas uniquement des outils, mais d’une organisation capable de piloter sa qualité avec discernement. Les entreprises matures sur ce sujet partagent quelques points communs : elles mesurent leurs progrès, elles hiérarchisent leurs efforts et elles lient la qualité à la performance réelle.

Les indicateurs ne servent pas qu’à mesurer la propreté des données : ils permettent de comprendre leur impact. Un meilleur taux de cohérence, c’est moins d’erreurs dans les reportings. Un délai de correction réduit, c’est une prise de décision plus rapide. Une donnée fiable, c’est une donnée utile.

C’est en établissant ce lien entre la donnée et la valeur qu’on dépasse la simple conformité pour entrer dans une logique de performance. L’objectif n’est pas la perfection, mais la progression continue.

Faire vivre la démarche dans le temps suppose de structurer le pilotage et de maintenir une dynamique collective. Quelques principes peuvent guider cette évolution :

La qualité des données n’est pas un projet ponctuel, mais un réflexe organisationnel. Sa réussite repose autant sur la rigueur des processus que sur la constance des équipes.

En définitive, auditer la qualité des données, c’est passer de la photographie à la transformation. C’est accepter de regarder la donnée telle qu’elle est pour mieux la maîtriser demain. C’est transformer un exercice de contrôle en levier d’amélioration continue, et faire de la confiance dans la donnée un actif mesurable et stratégique.

Chez Limpida, nous considérons que chaque audit est une opportunité de construire un système plus juste, plus transparent et plus performant. La donnée maîtrisée n’est pas un idéal lointain — c’est le résultat d’une culture, patiemment entretenue, où la qualité devient synonyme de fiabilité et d’efficacité durable.