L’IA générative s’est installée dans les organisations sans demander d’autorisation. Pas de comité de pilotage, pas de feuille de route officielle, parfois même pas de validation IT. Elle est arrivée par les usages, portée par les collaborateurs eux-mêmes, souvent avec de bonnes intentions : gagner du temps, mieux formuler, structurer une idée ou simplement aller plus vite.

Et c’est précisément ce mode d’adoption qui rend le sujet délicat.

Pendant que certaines entreprises réfléchissent encore à une stratégie IA, d’autres l’utilisent déjà au quotidien. Parfois de manière très basique, parfois sur des sujets bien plus sensibles qu’elles ne l’imaginent. Cette cohabitation crée un flou : d’un côté, des organisations qui ferment les yeux en espérant que le sujet se régule de lui-même ; de l’autre, celles qui dégainent chartes, interdictions et procédures avant même d’avoir compris les usages réels.

Dans les deux cas, le problème n’est pas l’IA. C’est le décalage entre les pratiques et le cadre.

L’enjeu n’est donc pas de savoir s’il faut encadrer l’IA générative, mais de déterminer à quel moment les règles deviennent nécessaires, lesquelles apportent réellement de la valeur, et comment éviter de transformer un levier d’efficacité en une nouvelle usine à gaz réglementaire. Car mettre des règles trop tôt freine l’adoption, tandis que ne pas en mettre du tout revient à accepter des risques que l’on ne maîtrise pas toujours, surtout quand ils deviennent visibles.

Tout l’équilibre consiste à placer le curseur au bon endroit, au bon moment.

L’IA générative pose un problème assez simple à formuler, mais complexe à gérer : elle fait beaucoup de choses, très vite, avec une apparente facilité. Et cette facilité donne parfois l’illusion qu’elle peut être utilisée sans cadre, comme un simple outil bureautique un peu plus intelligent que les autres.

En réalité, l’IA générative brouille plusieurs frontières en même temps.

Elle brouille d’abord la frontière entre outil personnel et outil professionnel. Un même modèle peut être utilisé le soir pour rédiger un message personnel, puis le lendemain pour produire un livrable interne. Ce glissement est presque invisible pour l’utilisateur, mais il pose immédiatement des questions de responsabilité, de confidentialité et de périmètre d’usage.

Elle brouille ensuite la frontière entre aide à la réflexion et production effective. Ce qui commence comme une ébauche ou une source d’inspiration peut très vite devenir un contenu final, intégré tel quel dans un rapport, une présentation ou une recommandation. Dans ce cas, ce n’est plus seulement l’IA qui “aide”, c’est l’IA qui produit — parfois sans que cela soit clairement assumé.

Autre point souvent sous-estimé : l’IA générative est très convaincante, même lorsqu’elle se trompe. Elle ne dit pas “je ne sais pas”, elle improvise. Et elle le fait avec un niveau de confiance qui peut facilement masquer des erreurs factuelles, des approximations ou des biais. Sans règles claires, le risque n’est pas tant l’erreur que l’erreur crédible.

Enfin, et c’est sans doute l’aspect le plus sensible, l’IA générative manipule des données. Des données internes, parfois sensibles. Des connaissances métiers. Des raisonnements stratégiques. Autrement dit, ce que l’entreprise a de plus critique. À partir du moment où ces éléments entrent dans le champ de l’IA, la question n’est plus uniquement technologique, elle devient juridique, organisationnelle et même réputationnelle.

Les règles ne sont donc pas là pour brider l’innovation ou ralentir les équipes. Elles servent à éviter que des usages anodins en apparence ne créent, par accumulation, des risques bien réels. Et surtout, à faire en sorte que l’IA générative reste un outil maîtrisé, plutôt qu’un acteur invisible dont on découvre les effets une fois que le problème est déjà là.

Toutes les utilisations de l’IA générative ne posent pas les mêmes enjeux. Tant que les usages restent marginaux et individuels, le besoin de règles est limité. En revanche, dès que l’IA touche aux données, aux décisions ou aux processus, l’absence de cadre devient rapidement problématique. Ces différents seuils permettent d’identifier le moment où les règles cessent d’être optionnelles.

À ce stade, l’IA générative est encore perçue comme un outil personnel d’augmentation de la productivité, utilisé à l’initiative de l’individu et sans inscription formelle dans l’organisation. Elle accompagne le travail, mais ne le structure pas encore. C’est une phase clé, car c’est souvent là que se forgent les premiers réflexes, bons ou mauvais :

Dans cette phase expérimentale, l’erreur la plus fréquente consiste à vouloir cadrer trop tôt. À l’inverse, le vrai risque n’est pas l’usage lui-même, mais l’absence de repères. Autoriser explicitement l’expérimentation, tout en posant quelques règles simples et compréhensibles, permet d’éviter que cette phase fondatrice ne s’installe dans le flou.

👉 À lire aussi : Pourquoi copier la gouvernance des données pour l’IA est une erreur ?

C’est souvent ici que les choses se compliquent. Pas parce que l’usage devient soudainement malveillant, mais parce que l’IA générative commence à manipuler des éléments qui n’appartiennent plus seulement à l’utilisateur, mais à l’entreprise. Même sans mauvaise intention, le risque change d’échelle.

À ce stade, l’absence de règles n’est plus un simple angle mort, c’est un facteur de risque actif. Le rôle du cadre n’est pas d’interdire l’usage de l’IA, mais de rendre explicite ce qui est autorisé, ce qui ne l’est pas, et dans quelles conditions. Sans cela, l’IA générative devient un accélérateur, y compris pour les mauvaises pratiques.

À partir du moment où les productions de l’IA générative sortent du cadre individuel, l’outil change de statut. Il ne s’agit plus seulement d’un assistant personnel, mais d’un facteur d’influence collective. Et qui dit influence dit responsabilité — même si l’IA, elle, ne signe rien.

À ce stade, les règles ne sont plus une option. Elles doivent clarifier les responsabilités, imposer des mécanismes de validation et rendre l’usage de l’IA explicite lorsqu’il influence une décision. L’IA peut éclairer, suggérer, accélérer, mais elle ne peut pas être un décideur fantôme.

Le dernier seuil est franchi lorsque l’IA générative ne se contente plus d’assister ponctuellement les utilisateurs, mais devient un élément structurant de l’activité. À ce stade, l’outil n’est plus accessoire : il influence directement la manière dont le travail est réalisé, et parfois même les résultats produits.

À ce niveau, l’encadrement de l’IA générative n’est plus un sujet d’expérimentation ou de sensibilisation. Il s’agit d’un enjeu de gouvernance à part entière. Les règles doivent être formalisées, partagées et suivies dans la durée, au même titre que celles qui encadrent les autres composants critiques du système d’information.

L’encadrement de l’IA générative est souvent abordé par le mauvais angle. Face à un sujet perçu comme nouveau, complexe et potentiellement risqué, la tentation est grande d’empiler des règles, des chartes et des principes généraux. Le problème n’est pas tant le manque de règles que leur mauvaise hiérarchisation. Toutes les règles ne se valent pas, et surtout, toutes n’ont pas le même impact sur les usages réels.

Certaines règles sont indispensables pour protéger l’organisation et ses données. D’autres sont utiles pour structurer les pratiques. Et certaines, soyons honnêtes, servent surtout à se donner bonne conscience. L’enjeu n’est donc pas d’encadrer l’IA générative à tout prix, mais de distinguer ce qui sécurise réellement les usages de ce qui complexifie inutilement le quotidien des équipes. Une bonne règle n’est pas celle qui rassure sur le papier, mais celle qui est comprise, appliquée et utile dans les situations concrètes.

Les règles juridiques et réglementaires constituent le socle minimal de tout encadrement de l’IA générative. Protection des données personnelles, respect de la confidentialité, propriété intellectuelle, obligations sectorielles : ces sujets ne sont pas optionnels. Dès lors que l’IA traite des données ou produit des contenus utilisés dans un cadre professionnel, le droit s’applique, qu’on le veuille ou non. Ignorer ces règles ne relève pas de l’audace, mais de l’imprudence.

Pour autant, ces règles ne suffisent pas à encadrer les usages réels de l’IA générative. Elles définissent ce qui est légal ou illégal, mais disent rarement comment travailler concrètement au quotidien. Une règle juridique mal traduite opérationnellement devient vite incompréhensible pour les utilisateurs, qui finissent soit par l’ignorer, soit par surinterpréter les risques. Le vrai enjeu consiste donc à transformer les obligations réglementaires en règles compréhensibles et actionnables, sans faire porter aux équipes la charge d’une interprétation juridique permanente.

Les règles éthiques sont souvent les premières à être mises en avant lorsqu’il est question d’IA générative. Transparence, équité, non-discrimination, explicabilité : les intentions sont louables et les principes largement partagés. Le problème n’est pas leur existence, mais la manière dont ils sont formulés. Trop souvent, l’éthique de l’IA se limite à une série de grands principes abstraits, difficiles à contester, et tout aussi difficiles à appliquer concrètement.

Dans la pratique, une règle éthique n’a de valeur que si elle est traduite en situations réelles d’usage. Dire que l’IA doit être utilisée de manière responsable ne suffit pas à guider un collaborateur face à un cas concret. En revanche, expliciter ce qui est acceptable ou non dans un contexte métier donné permet d’éviter les dérives sans transformer l’éthique en injonction morale. Une éthique efficace n’est pas celle qui moralise, mais celle qui aide à décider, surtout lorsque les limites ne sont pas évidentes.

Les règles métiers sont souvent absentes des premiers cadres mis en place autour de l’IA générative. Pourtant, ce sont elles qui déterminent si l’outil crée réellement de la valeur ou s’il génère surtout du bruit. Une règle métier ne cherche pas à dire si l’IA est légale ou morale, mais si son usage est pertinent dans un contexte opérationnel donné. Et c’est précisément ce niveau de granularité qui manque le plus dans les approches trop générales.

Ces règles doivent répondre à des questions très concrètes : pour quels cas d’usage l’IA est-elle autorisée ? À quelles étapes d’un processus peut-elle intervenir ? Quels types de résultats peuvent être utilisés tels quels, lesquels nécessitent une relecture experte, et lesquels sont à proscrire ? Sans ces repères, l’IA est utilisée de manière opportuniste, parfois brillante, parfois totalement hors sujet. Les règles métiers ne brident pas l’innovation ; elles permettent d’éviter que l’IA produise des résultats “corrects” sur le fond mais inexploitables dans la réalité du terrain.

Les règles de gouvernance visent à répondre à une question simple en apparence : qui décide quoi lorsqu’il est question d’IA générative. Qui est responsable des usages ? Qui arbitre en cas de doute ? Qui fait évoluer les règles lorsque les pratiques changent ? Sans gouvernance claire, l’IA devient un sujet diffus, traité au cas par cas, avec un risque élevé d’incohérence entre équipes.

Pour autant, une gouvernance trop lourde peut rapidement devenir contre-productive. Multiplier les comités, les validations ou les circuits de décision ralentit les usages sans nécessairement les sécuriser davantage. Une gouvernance efficace repose moins sur des instances que sur des rôles clairement identifiés, des responsabilités assumées et des circuits de décision courts. Autrement dit, mieux vaut une gouvernance simple et active qu’un dispositif complexe que personne n’ose réellement activer.

👉 À lire aussi : Gouverner l’IA en entreprise : rôles, règles et pilotage

Les règles techniques et de sécurité sont souvent perçues comme le domaine réservé de l’IT, voire comme un frein aux usages. En réalité, elles jouent un rôle clé dans la maîtrise de l’IA générative, car ce sont elles qui déterminent où, comment et avec quels outils l’IA peut être utilisée. Choisir des solutions validées, maîtriser les flux de données et limiter les intégrations non contrôlées permet de réduire considérablement les risques sans alourdir inutilement le quotidien des utilisateurs.

Le principal écueil consiste à transformer ces règles en une liste d’interdictions techniques incompréhensibles pour les métiers. Une règle de sécurité efficace ne se contente pas de dire “non”, elle explique pourquoi et propose des alternatives. À défaut, les usages ne disparaissent pas : ils se déplacent. Et une IA utilisée hors des outils autorisés est toujours plus risquée qu’une IA utilisée dans un cadre technique maîtrisé.

Les règles d’usage sont celles qui font le lien entre les principes et la réalité du terrain. Elles traduisent l’ensemble des règles juridiques, éthiques, métiers, de gouvernance et de sécurité en gestes concrets du quotidien. Ce sont aussi, très souvent, les seules règles réellement lues et appliquées par les utilisateurs. Lorsqu’elles sont bien formulées, elles sécurisent les usages sans alourdir les pratiques.

À l’inverse, des règles d’usage trop vagues ou trop nombreuses perdent rapidement leur efficacité. Une bonne règle opérationnelle est courte, contextualisée et immédiatement compréhensible : ce que je peux faire, ce que je dois éviter, et à qui m’adresser en cas de doute. Lorsqu’elles remplissent ce rôle, ces règles deviennent un véritable facilitateur d’adoption. Lorsqu’elles échouent, elles ne sont pas ignorées par négligence, mais par nécessité.

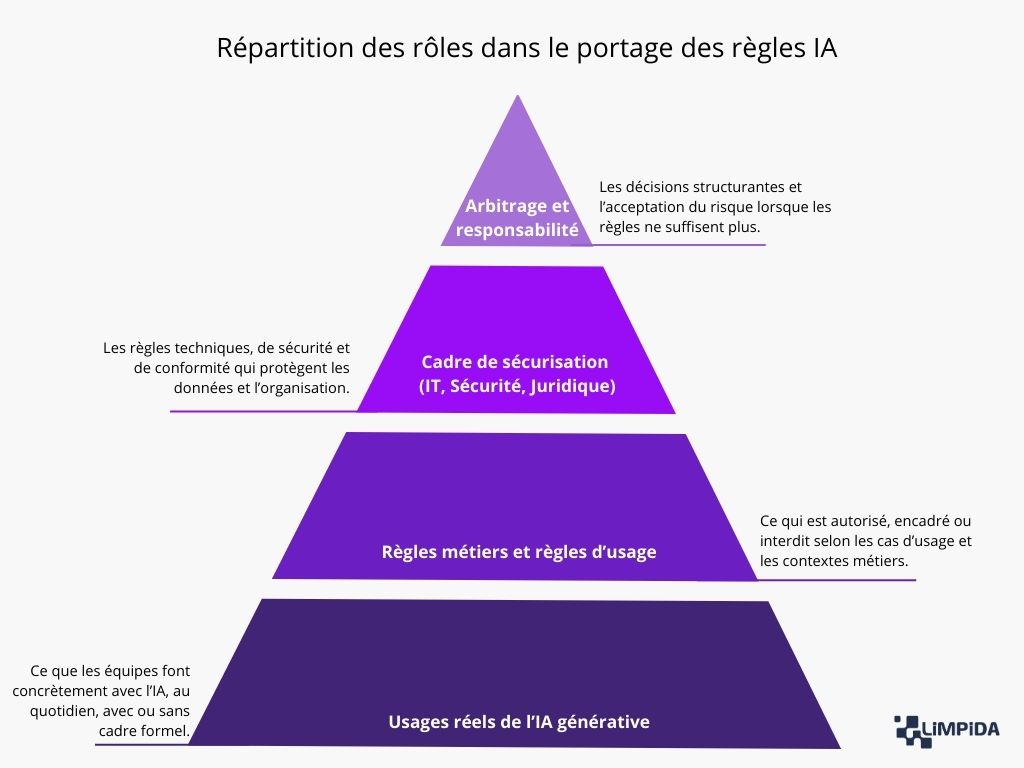

L’une des erreurs les plus fréquentes consiste à chercher un propriétaire unique des règles de l’IA générative. En réalité, aucun rôle ne peut, à lui seul, couvrir l’ensemble des enjeux. Les règles efficaces sont presque toujours le résultat d’un équilibre entre plusieurs acteurs, chacun intervenant à un niveau précis.

Définir les règles de l’IA générative n’est donc pas un exercice solitaire, ni un sujet réservé à une seule fonction. C’est un travail collectif, qui repose autant sur la coordination que sur la répartition claire des responsabilités. Lorsque chacun joue son rôle, les règles cessent d’être perçues comme une contrainte et deviennent un véritable cadre de confiance pour les usages.

👉 À lire aussi : L’IA générative et ses impacts sur la gouvernance des données

C’est sans doute la crainte la plus répandue autour de l’encadrement de l’IA générative : qu’en voulant sécuriser les usages, on finisse par les étouffer. Cette crainte n’est pas infondée. Beaucoup d’organisations ont déjà vécu ce scénario avec d’autres sujets technologiques : des règles trop nombreuses, trop abstraites ou trop rigides, qui transforment un outil prometteur en contrainte quotidienne.

La bonne nouvelle, c’est que ce n’est pas une fatalité. Mettre des règles ne signifie pas forcément ralentir. À condition, toutefois, de respecter quelques principes clés, souvent plus organisationnels que techniques.

D’abord, il est essentiel de partir des usages existants, et non des usages idéaux. Les règles efficaces ne sont pas celles qui anticipent tous les scénarios possibles, mais celles qui cadrent ce que les équipes font déjà — ou sont sur le point de faire. Observer, écouter, comprendre avant de formaliser permet d’éviter des règles hors-sol, perçues comme arbitraires ou déconnectées du réel.

Ensuite, les règles doivent être proportionnées au niveau de risque. Tous les usages de l’IA générative ne nécessitent pas le même degré de contrôle. Appliquer le même cadre à une aide à la rédaction et à un outil intégré dans un processus décisionnel critique est non seulement inefficace, mais contre-productif. Plus le risque est élevé, plus le cadre doit être structuré ; plus l’usage est léger, plus les règles doivent rester simples.

Un autre levier souvent sous-estimé consiste à remplacer les interdictions générales par des règles actionnables. Dire “l’IA est interdite sur les données sensibles” est juridiquement rassurant, mais opérationnellement flou. En revanche, fournir des exemples concrets de ce qui est autorisé, toléré ou proscrit permet aux utilisateurs de se situer rapidement, sans avoir à interpréter eux-mêmes des principes abstraits.

Il est également important de rendre les règles visibles et vivantes. Une charte IA déposée sur un intranet et jamais relue n’a aucun impact réel. À l’inverse, des règles intégrées aux outils, rappelées au bon moment, ou portées par des relais métiers ont beaucoup plus de chances d’être comprises et appliquées. Une règle utile est une règle qu’on rencontre au moment où l’on en a besoin, pas six mois avant.

Enfin, mettre des règles sans freiner l’adoption suppose d’accepter qu’elles évoluent dans le temps. Les usages de l’IA générative changent vite, parfois plus vite que les cadres formels. Prévoir dès le départ des mécanismes d’ajustement, de retour d’expérience et de clarification permet d’éviter que les règles ne deviennent obsolètes ou systématiquement contournées.

En résumé, les règles qui freinent l’adoption ne sont pas celles qui existent, mais celles qui sont mal conçues. Lorsqu’elles partent des usages, qu’elles sont proportionnées, compréhensibles et évolutives, elles cessent d’être perçues comme un frein. Elles deviennent au contraire un facteur de confiance, pour les utilisateurs comme pour l’organisation.

Encadrer l’IA générative est nécessaire, mais ce n’est pas neutre. Un cadre mal conçu peut créer presque autant de problèmes qu’une absence totale de règles. Identifier ces risques permet justement d’éviter les dérives les plus fréquentes.

Encadrer l’IA générative est un exercice d’équilibriste. Trop peu de règles expose l’organisation à des risques mal maîtrisés ; trop de règles étouffe les usages et pousse les pratiques dans l’ombre. Le véritable risque n’est donc pas l’encadrement en lui-même, mais un encadrement mal calibré, déconnecté des usages réels et incapable d’évoluer.

Un cadre efficace ne cherche pas à tout prévoir, ni à tout verrouiller. Il vise à créer suffisamment de clarté pour sécuriser, sans freiner, et suffisamment de souplesse pour accompagner l’évolution des usages. C’est à cette condition que les règles cessent d’être perçues comme une contrainte et deviennent un levier de maîtrise durable.

L’IA Act est souvent évoqué comme la future réponse à tous les enjeux de l’IA générative. Pour certains, il constitue une menace réglementaire majeure ; pour d’autres, un cadre rassurant qui viendrait enfin clarifier les usages. La réalité est, comme souvent, plus nuancée. L’IA Act n’a pas vocation à définir comment utiliser concrètement l’IA générative au quotidien dans une organisation. Il fixe avant tout un cadre de conformité, pas un mode d’emploi opérationnel.

Concrètement, l’IA Act introduit une approche par niveaux de risque, avec des obligations plus ou moins fortes selon les usages. Cette logique est intéressante, car elle rejoint un principe clé évoqué plus tôt : tous les usages ne se valent pas et ne doivent pas être encadrés de la même manière. En revanche, l’IA Act s’adresse principalement aux fournisseurs et aux déployeurs de systèmes d’IA à risque élevé. De nombreux usages internes de l’IA générative, notamment expérimentaux ou d’assistance, restent en dehors de son périmètre direct.

L’erreur serait donc de considérer l’IA Act comme un substitut à une réflexion interne sur les règles d’usage. Le règlement pose des garde-fous indispensables, mais il ne répond pas aux questions opérationnelles que se posent les équipes : peut-on utiliser l’IA sur tel type de document ? Qui valide les résultats ? Comment intégrer l’IA dans un processus existant ? Ces réponses relèvent toujours de l’organisation elle-même, de ses métiers, de sa gouvernance et de sa culture du risque.

En pratique, l’IA Act doit être vu comme un socle, pas comme un cadre clé en main. Il fixe des limites non négociables et des obligations minimales, mais laisse aux organisations la responsabilité de construire des règles adaptées à leurs usages réels. Autrement dit, se conformer à l’IA Act est nécessaire, mais largement insuffisant pour encadrer efficacement l’IA générative au quotidien.